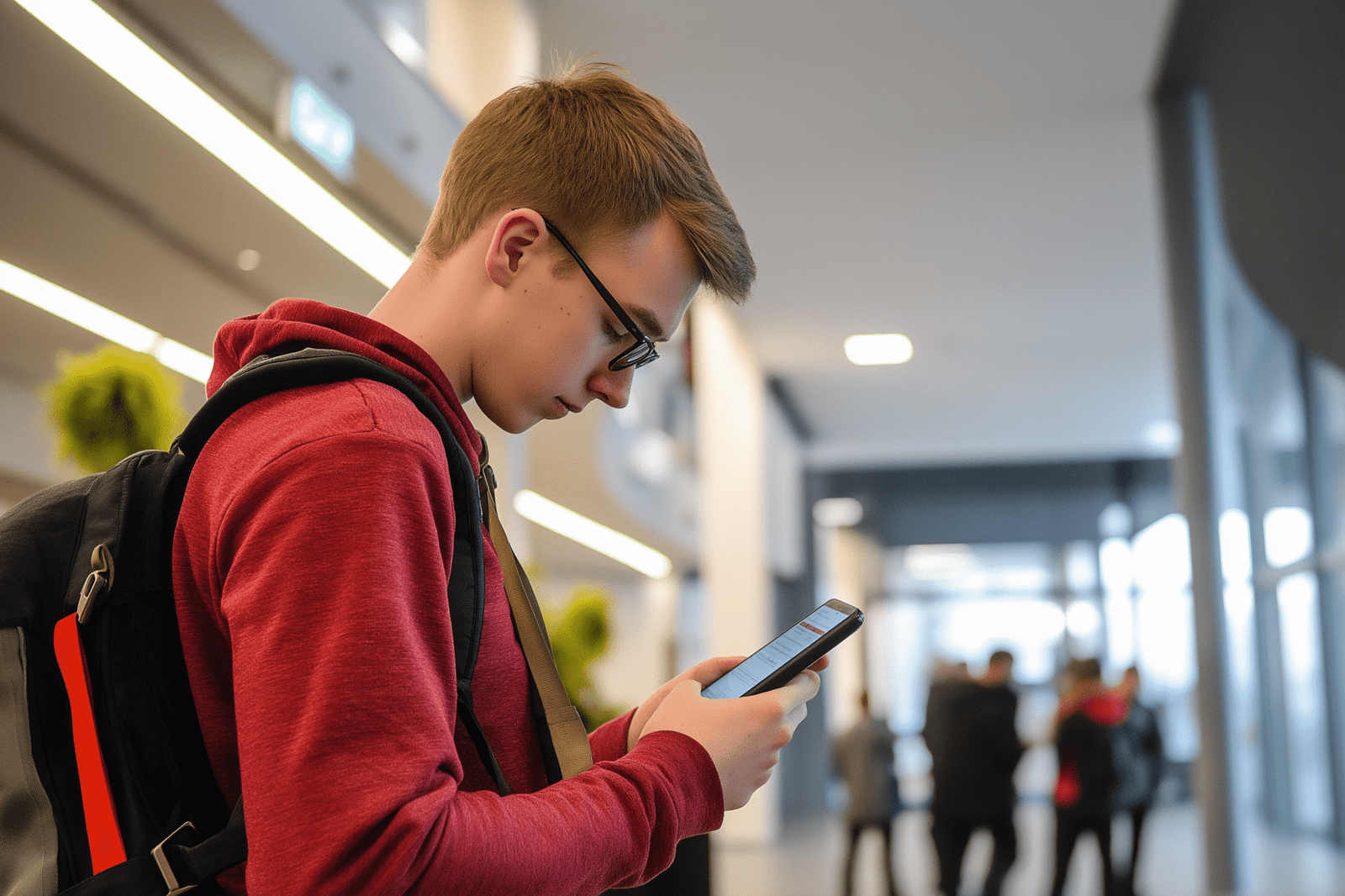

Sécurité renforcée pour les adolescents sur Facebook : les nouvelles mesures de Meta

Dans un monde de plus en plus numérique, la protection des mineurs en ligne est devenue une préoccupation majeure. Meta, la maison mère de Facebook et Instagram, se lance à son tour dans cette bataille en renforçant les mesures de contrôle parental sur ses plateformes. Zoom sur ces nouvelles fonctionnalités pour les comptes adolescents.

Un déploiement progressif à travers le monde

Initialement lancés dans quatre pays – États-Unis, Canada, Australie et Royaume-Uni – les comptes adolescents de Meta pour Facebook et Messenger s’inscrivent dans une stratégie de déploiement mondial progressif. Faisant suite à la mise en place sur Instagram en 2024, ces comptes sont réservés aux utilisateurs âgés de 13 à 17 ans.

Fonctionnalités des comptes adolescents

Limitation des contacts et contenus sensibles

Les comptes adolescents ont pour principal objectif de limiter les contacts extérieurs et l’accès à des contenus sensibles. Les utilisateurs de moins de 16 ans ne peuvent modifier ces paramètres qu’avec l’autorisation d’un parent. Cela contribue à créer un environnement numérique plus sûr pour les adolescents en limitant les interactions potentiellement dangereuses.

Gestion du temps d’écran

Un autre aspect important de ces comptes est la gestion du temps d’écran. Les notifications sont désactivées la nuit et un rappel s’affiche après 60 minutes d’utilisation. Ces mesures visent à encourager les jeunes à adopter une utilisation plus saine et équilibrée des réseaux sociaux.

Contact limité aux amis existants

Dans le but de renforcer la sécurité des adolescents, ces derniers ne peuvent être contactés que par leurs amis existants sur les plateformes. Cela réduit les risques de harcèlement ou d’exploitation en ligne.

Une réponse à la pression réglementaire mondiale

En parallèle, Instagram a durci ses règles pour les mineurs. Les utilisateurs de moins de 16 ans n’ont plus accès aux vidéos en direct sans validation parentale. Le floutage automatique des images sensibles reste activé, sauf si les parents décident de le désactiver. Ces mesures sont une réponse à la pression réglementaire mondiale visant à mieux protéger les jeunes en ligne.

La tendance suivie par TikTok et d’autres plateformes

Face à cette pression réglementaire, d’autres plateformes suivent la tendance. TikTok, par exemple, a lancé en Europe une option permettant aux parents de fixer des durées d’écran. Cette logique de contrôle intégré devient une norme imposée, et Meta espère rester compétitive sans perdre son jeune public ni fâcher les régulateurs.

Une position plus responsable pour Meta

En multipliant ces outils, Meta tente de s’installer dans une position plus responsable. L’entreprise sait qu’elle joue sa réputation sur ce terrain. Cependant, pour convaincre les familles comme les gouvernements, il faudra des preuves concrètes d’efficacité. Et surtout, que ces mesures ne soient pas contournables.

Conclusion : Une démarche nécessaire, mais des défis restent à relever

En fin de compte, ces nouvelles mesures de Meta sont une étape nécessaire pour la protection des jeunes utilisateurs. Cependant, l’efficacité de ces mesures reste à prouver et il est crucial qu’elles ne soient pas facilement contournables. Il est certain que la sécurité en ligne des mineurs continuera d’être un sujet de discussion et d’innovation dans les années à venir.

Produits qui pourraient vous intéresser

Share this content: